Otro capítulo de la pelea en el PJ, una foto que hizo ruido y la historia reciente que incomoda

Otro capítulo de la pelea en el PJ, una foto que hizo ruido y la historia reciente que incomoda

Reforma laboral: el apuro del Gobierno, el error del artículo 44 y la financiación del sindicalismo

Se les “incendió” un sueño, pero se casaron y lograron cumplirlo

VIDEO. La alegría da la vuelta al mundo: imponente festejo del Año Nuevo Chino

Fuerte choque en 7 y 46: heridos y cortes en pleno centro de La Plata

Bochas: auge, ocaso y renacimiento de una parte de la identidad platense

La costa bonaerense en retroceso: menos playas, zonas en riesgo y un patrimonio natural amenazado

Domingo soleado para disfrutar al aire libre en La Plata: cuándo llegan las lluvias a la Región

Renace “Julio Ghione” el club que apuesta por las personas con discapacidad

La UCR se acerca a días decisivos para definir si adelanta la interna

La Provincia exporta más, pero se contrae el peso de la industria

La recaudación en la Provincia mostró un alivio con sabor a poco

FATE, la epidemia que arrastra empresas y el riesgo de un cisne negro autoinfligido

“Me podrían haber matado” Salvaje ataque a la salida de un boliche

VIDEO. Incendio, explosión y otra jornada marcada por la tensión en La Plata

¿Esto es amor?: relaciones con inteligencias artificiales y citas con cosplayers

Los números de este domingo del Cartonazo para jugar por $1.000.000

La culpa: cómo transformarla en responsabilidad y dejar de vivir bajo su sombra

Ellos las prefieren argentinas: los famosos y un amor que trascendió fronteras

“Les va a costar volver” LLA contra el PJ por la amenaza de derogar la reforma laboral

Atacar, atacar, atacar: Trump desafía a la Corte Suprema y aplica aranceles más altos

Villarruel y la Iglesia, en contra de bajar la edad de imputabilidad

La morosidad toca niveles máximos y en billeteras duplica a la de los bancos

Cómo convivirán en el trabajo del futuro las cinco generaciones

Estimado lector, muchas gracias por su interés en nuestras notas. Hemos incorporado el registro con el objetivo de mejorar la información que le brindamos de acuerdo a sus intereses. Para más información haga clic aquí

A medida que avanza, demuestra una capacidad inédita para realizar videos falsos, textos coherentes y hasta clonar voces. Los expertos anticipan una oleada de engaños

La inteligencia artificial puede ser una aliada para algunos trabajos, pero también un peligro latente / web

Así como la inteligencia artificial genera grandes esperanzas lo mismo que enormes dudas respecto al futuro de muchos trabajos o incluso del arte, un nuevo aspecto de este desarrollo tecnológico viene siendo enfocado bajo la lupa de los especialistas no sin poca preocupación: las estafas virtuales, según alertan, pueden no sólo crecer sino perfeccionarse al punto de hacerse casi indetectables. ¿Estamos atrapados ante el avance de la IA?

Uno de los ejemplos que los expertos están mencionando cada vez con más frecuencia por estos días es la posibilidad que da esta tecnología de falsificar la voz de cualquiera y así utilizar esa herramienta para realizar una estafa.

Según revela el sitio especializado Techspot, de hecho, una pareja canadiense de adultos mayores recibió en los últimos días la llamada de “su nieto”. Después de decirles que estaba en la cárcel, les pidió que enviasen una fianza de 6 mil dólares canadienses (algo así como 2 millones de pesos argentinos) para poder salir de prisión, una situación que llevó al matrimonio a retirar 3.000 dólares de un banco y hacer lo propio en otra entidad. Pero, para su suerte, al llegar a esta el director les informó de que se trataba de una estafa cada vez más popular y les informó que ya había tenido que frenar casos similares por otros usuarios afectados.

Plataformas como ElevenLabs permiten crear un diálogo simulando cualquier voz, solo se necesitan 30 segundos de grabación, por lo que los delincuentes pueden hacer una llamada previa al familiar para capturar esa información y luego ir por la víctima.

Lo que dice esta inteligencia artificial es el resultado de un texto que crean los atacantes, aprovechando que el software analiza cada aspecto de la voz como el género, la edad y el acento para encontrar patrones y hacer la copia. Las voces falsificadas a través de la IA todavía tienen mucho camino por recorrer antes de ser indistinguibles de las humanas pero, en una videollamada de corta duración, son capaces de engañar hasta el más experimentado.

Sobre todo, si la persona que aparece en la pantalla del móvil solicitando un depósito por alguna fatalidad (accidente, robo o emergencia), coincide con la voz y la apariencia de quien dice ser.

LE PUEDE INTERESAR

Devuelven al mar a dos lobos y un elefante marinos en San Clemente

LE PUEDE INTERESAR

Quiénes son las mujeres más destacadas en la ciencia

“La IA puede ser utilizada para crear malware más sofisticado y difícil de detectar -apunta Pablo Rodríguez Romeo, perito informático forense y especialista en seguridad-. Los ciberdelincuentes pueden usar algoritmos de aprendizaje automático para desarrollar malware que evada las defensas de seguridad y se propague rápidamente a través de redes y sistemas. Pero también, para desarrollar malware que se adapte y evolucione a medida que las defensas de seguridad cambian”.

En cuanto a los fraudes financieros, Rodríguez Romeo apunta que la IA “puede ser utilizada para llevar a cabo fraudes como el robo de información de tarjetas de crédito o el fraude de cuentas bancarias. Además, para analizar y seleccionar a las víctimas más vulnerables y generar transacciones fraudulentas que parezcan legítimas. Todo esto nos permite vislumbrar cómo la IA está siendo utilizada cada vez más por los ciberdelincuentes para llevar a cabo sus actividades delictivas. Por eso, es importante que las organizaciones y los individuos estén al tanto de las amenazas y tomen medidas de seguridad adecuadas para protegerse”.

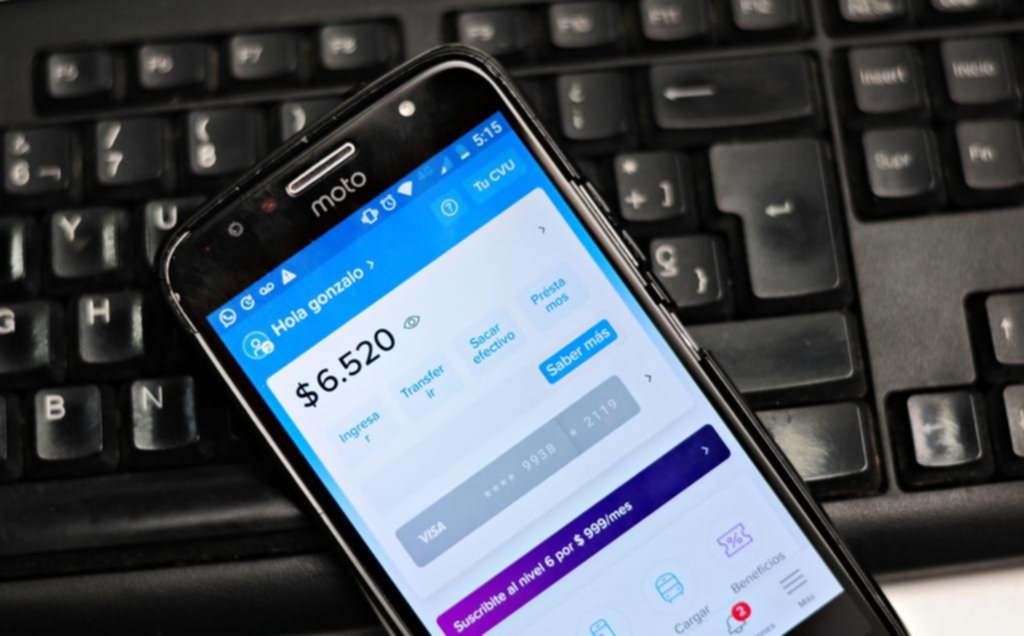

Los expertos advierten que la Inteligencia Artificial se usa para estafas bancarias

Aunque la inteligencia artificial lleva la modalidad de robo a un punto de engaño muy alto, siempre hay que dudar ante este tipo de situación. Lo primero es que en caso de una llamada, en la que alguien pida ayuda inmediatamente, nunca se debe dar el nombre de algún familiar, porque eso le servirá al delincuente para crear un lazo y empezar a actuar como esa persona, lo mejor será esperar hasta que sea él o ella el que revele su identidad.

En caso dar el nombre por error o que del otro lado lo adivinen, la mejor alternativa es llamar directamente a esa persona y asegurarse de que la situación es real. Los delincuentes siempre van a llamar de números desconocidos y crean la excusa que es por el problema que están pasando, por eso su celular no sirve o lo tienen detenido. Otro punto clave es nunca dar información personal como dirección, teléfono, nombres, números de cuenta y correos electrónicos porque quizás no se efectúe un robo de dinero en ese momento, pero esa data le servirá al delincuente en el futuro.

Los estafadores usan esta tecnología para clonar no sólo voces sino también rostros

Hace poco, según reporta la agencia Xinhua, un empresario llamado Wan Guo transfirió 3 mil dólares de su cuenta, tras recibir una comunicación por WeChat de una mujer cuyo rostro y voz se parecían mucho a las de su esposa. La excusa fue que había tenido un accidente con su vehículo y tenía que pagar los daños ocasionados a otro conductor. Para escapar a la emboscada de la suspicacia, insistía en que debía ser inmediato. “Aunque había algo artificial en su forma de expresarse, no se me ocurrió desconfiar ya que las expresiones del rostro e incluso la voz, eran las de mi esposa”, declaró el empresario.

Los investigadores del caso descubrieron que los estafadores conocían los hábitos del matrimonio. Además sabían que la mujer tenía un canal de cocina en una red social y de allí sacaron las capturas de su rostro y voz para maquinar el deepfake.

Intuyendo algo fuera de lugar, el empresario contactó por mensaje a su mujer al cabo de unos instantes y esta le negó los hechos. De inmediato, Guo notificó a la institución bancaria que procedió a bloquear la operación, impidiendo la transferencia.

Varios casos similares aparecen en las páginas del Washington Post, donde indican que, según datos de la Federal Trade Commission (FTC), este tipo de fraudes se coloca entre los segundos más frecuentes, con más de 36.000 denuncias.

El temor es que algunos timadores comenzaron a utilizando esta tecnología para clonar los rostros de influencer y streamers, para reclamar productos y regalías a las empresas que los contratan.

En la mayoría de los intentos, reconocen quienes trabajan en el tema, es difícil detectar la trampa, sobre todo porque el tono de urgencia vuelve menos reflexiva a la víctima. El tema resulta más complicado si el que recibe la llamada es mayor y desconoce estas tecnologías.

ESTA NOTA ES EXCLUSIVA PARA SUSCRIPTORES

HA ALCANZADO EL LIMITE DE NOTAS GRATUITAS

Para disfrutar este artículo, análisis y más,

por favor, suscríbase a uno de nuestros planes digitales

¿Ya tiene suscripción? Ingresar

Full Promocional mensual

$740/mes

*LOS PRIMEROS 3 MESES, LUEGO $6990

Acceso ilimitado a www.eldia.com

Acceso a la versión PDF

Beneficios Club El Día

Básico Promocional mensual

$570/mes

*LOS PRIMEROS 3 MESES, LUEGO $4500

Acceso ilimitado a www.eldia.com

Diario El Día de La Plata, fundado el 2 de Marzo de 1884.

© 2026 El Día SA - Todos los derechos reservados.

Registro DNDA Nº RL-2024-69526764-APN-DNDA#MJ Propietario El Día SAICYF. Edición Nro. 6986 Director: Raúl Kraiselburd. Diag. 80 Nro. 815 - La Plata - Pcia. de Bs. As.

Bienvenido

Estimado lector, muchas gracias por su interés en nuestras notas. Hemos incorporado el registro con el objetivo de mejorar la información que le brindamos de acuerdo a sus intereses. Para más información haga clic aquí

Ante cualquier inconveniente durante el inicio de sesión, por favor escribanos a sistemas@eldia.com

Bienvenido

Estimado lector, con sólo registrarse tendrá acceso a 80 artículos por mes en forma gratuita. Para más información haga clic aquí

DATOS PERSONALES

Ante cualquier inconveniente durante el inicio de sesión, por favor escribanos a sistemas@eldia.com

¿Querés recibir notificaciones de alertas?

Para comentar suscribite haciendo click aquí