El gobierno consiguió en el Senado la sanción de la Ley de Reforma Laboral

El gobierno consiguió en el Senado la sanción de la Ley de Reforma Laboral

Oficial: cuánto costará viajar en micro en La Plata desde el domingo

El revés de Kicillof en el Senado reavivó la disputa con La Cámpora

Se aprobó la Ley de Reforma Penal Juvenil y la edad de imputabilidad bajará a 14 años

Frente a frente por Kim Gómez “¿Por qué no me dejaste bajar a la nena?”

Cambios en Economía: asume Federico Furiase como nuevo secretario de Finanzas

Arranque de año sin clases en la UNLP: docentes universitarios paran una semana

Escala la tensión en el Caribe: EE UU piensa en "una toma amistosa de Cuba"

Dura respuesta del "Huevo" Acuña ante las acusaciones por la salida de Gallardo de River

El incendio en el depósito de La Plata: cómo sigue la causa penal

Le instaló un aire acondicionado y le "desaparecieron" 30 mil dólares: detuvieron a su cuñado

VIDEO | El fuerte cruce entre Julio Bazán con un policía en medio de un móvil

Este finde se sale en La Plata: la agenda de espectáculos con música, shows, teatro y más

Estatales bonaerenses también anunciaron un paro y se suman a docentes y judiciales

Vestuario caliente en River: imperdible cruce al aire por la salida de Gallardo

¿Mirtha cambia de canal?: las propuestas que recibió La Chiqui

Ofrecimiento de personal y empresas para reparación de viviendas y service del hogar

AUBASA se presentó para concesionar tramos de la Autopista Ricchieri

Detectan en el cielo de La Plata un objeto con "forma de boomerang" y estudian si es un OVNI

Murió Darío Lopérfido, referente de la cultura, ex pareja de Esmeralda Mitre

Domínguez: "Me fui de Estudiantes siendo feliz y sé que un día es probable que vuelva"

VIDEO. El efusivo festejo de "Chiqui" Tapia tras el campeonato de Lanús ante Flamengo en Brasil

Se sortearon los cruces de octavos de final de la Champions League y habrá dos duelos estelares

Estimado lector, muchas gracias por su interés en nuestras notas. Hemos incorporado el registro con el objetivo de mejorar la información que le brindamos de acuerdo a sus intereses. Para más información haga clic aquí

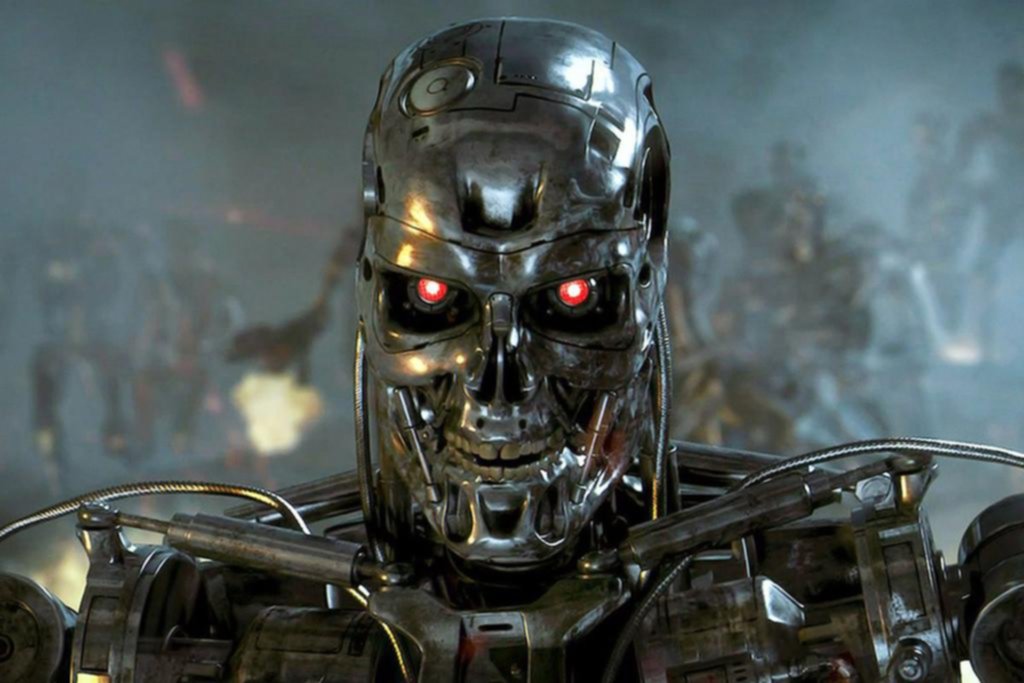

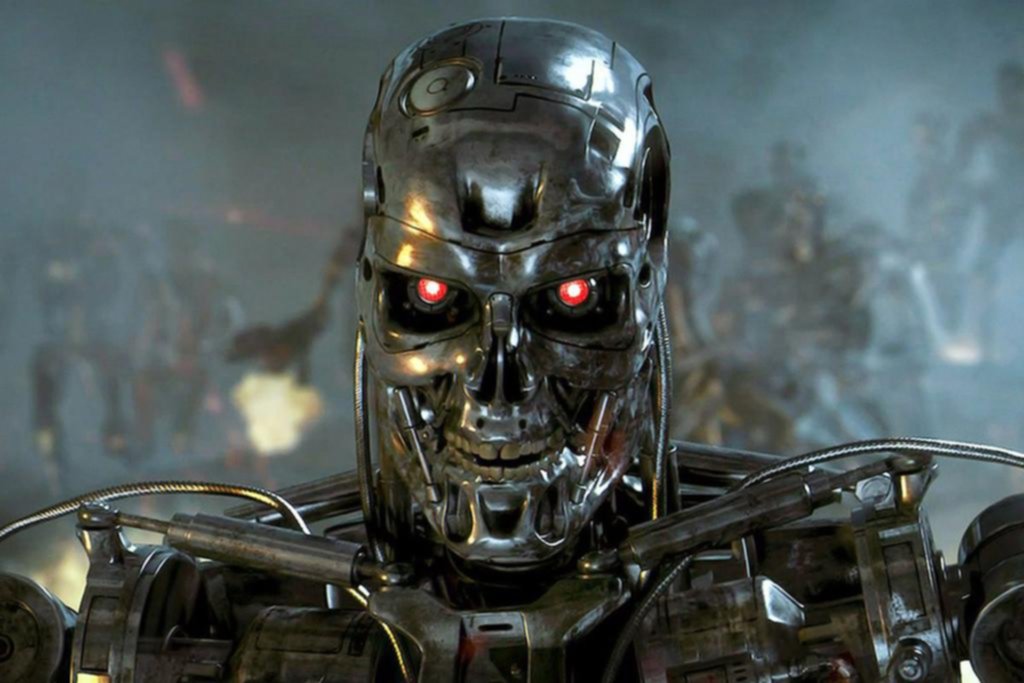

Una ex ingeniera de Google que trabajó en un proyecto militar advirtió que drones y aviones no tripulados con Inteligencia Artificial pueden provocar atrocidades no programadas

En el año 2015, investigadores, científicos y empresarios en el campo de la inteligencia artificial (IA), incluyendo algunos de la talla del astrónomo fallecido Stephen Hawking y del emprendedor Elon Musk, habían advertido sobre la necesidad de prohibir robots militares que, según ellos, podrían hacer más fáciles y factibles las guerras.

Y aseguraban que los “robots soldados” eran una posibilidad para “dentro de unos años y no décadas”.

Todo parecía una exageración, incluso cuando apuntaban que la creación de estas armas significaría una tercera revolución militar comparable a lo que en su momento significó la invención de la pólvora y las armas nucleares, hitos que empeoraron las amenazas a la paz a nivel mundial.

¿Exageración? A la luz de las declaraciones que se conocieron en las últimas horas de una ex ingeniera de software de Google llamada Laura Nolan, no lo pareciera, como tampoco cuando la propia ONU, el año pasado, dio una señal de alarma sobre el peligro que plantean los llamados “robots asesinos”.

¿Qué dijo la ingeniera Nolan? Pues que los robots asesinos y la Inteligencia Artificial podrían terminar conspirando contra la humanidad.

En una entrevista con el diario británico The Guardian, la ex ingeniera de Google señaló que “la principal amenaza es la falta de control humano, ya que estos robots podrían hacer cosas calamitosas para las que no fueron programados originalmente”.

LE PUEDE INTERESAR

Logran salvar a 6 de las 7 orcas varadas en Mar Chiquita

LE PUEDE INTERESAR

Presentan un láser quirúrgico platense

La probabilidad de un desastre es proporcional a la cantidad de robots en un mismo lugar

Y Nolan sabe de lo que habla. Fue reclutada por Google para su controversial proyecto Maven, que permitiría asistencia en IA y tecnología al Ministerio de Defensa de Estados Unidos, proyecto que tuvo como principal objetivo el usar la Inteligencia Artificial para mejorar drones militares.

El plan de Maven era construir sistemas de IA que fueran inteligentes y capaces de seleccionar objetivos enemigos distinguiendo entre personas y objetos. Fue tan polémico, que el proyecto fue eliminado por la misma Google. Y si bien su contrato expiró en marzo de este año, Nolan renunció al trabajo después de que se “preocupara cada vez más desde el punto de vista ético”.

Aún cuando no hay evidencias de que Google esté tras la creación y desarrollo de armas que se manejan de forma autónoma, Nolan advirtió sobre los peligros que esto conlleva.

“La probabilidad de un desastre es proporcional a cuántas de estas máquinas estarán en un área particular a la vez”, explicó.

Lo que ella está viendo son posibles atrocidades y asesinatos ilegales incluso bajo las leyes de la guerra, especialmente si se implementan cientos o miles de estas máquinas.

“Podría haber accidentes a gran escala porque estas cosas comenzarán a comportarse de manera inesperada -asegura- es por eso que cualquier sistema de armas avanzado debería estar sujeto a un control humano significativo. De lo contrario, deben ser prohibidos porque son demasiado impredecibles y peligrosos”.

Otra de las cosas que preocupan a Nolan es que estas armas se prueban en escenarios reales de guerra.

“La otra cosa aterradora de estos sistemas de guerra autónomos es que solo puedes probarlos realmente desplegándolos en una zona de combate real -dice- tal vez eso está sucediendo con los rusos actualmente en Siria, ¿quién sabe?, o con el ejército de los Estados Unidos en lugares como Afganistán”.

“Si se está probando una máquina que está tomando sus propias decisiones sobre el mundo que lo rodea -añadió- entonces tiene que ser en tiempo real. Además, ¿cómo se entrena un sistema que se ejecuta únicamente en software para detectar comportamientos humanos sutiles o discernir la diferencia entre cazadores e insurgentes? ¿Cómo distingue la máquina de matar en su propio vuelo sobre un combatiente de 18 años y otro de 18 años que está cazando conejos? Es muy peligroso”.

Acerca de su trabajo, Nolan explicó que “como ingeniero de confiabilidad del sitio, mi experiencia en Google consistía en garantizar que nuestros sistemas e infraestructuras se mantuvieran en funcionamiento, y esto es con lo que se suponía que debía ayudar a Maven. No participé directamente con las armas, pero me di cuenta que podía formar parte de una cadena de asesinatos”.

Destacan que sin control humano, las máquinas de guerra podrían provocar calamidades

ESTA NOTA ES EXCLUSIVA PARA SUSCRIPTORES

HA ALCANZADO EL LIMITE DE NOTAS GRATUITAS

Para disfrutar este artículo, análisis y más,

por favor, suscríbase a uno de nuestros planes digitales

¿Ya tiene suscripción? Ingresar

Full Promocional mensual

$740/mes

*LOS PRIMEROS 3 MESES, LUEGO $6990

Acceso ilimitado a www.eldia.com

Acceso a la versión PDF

Beneficios Club El Día

Básico Promocional mensual

$570/mes

*LOS PRIMEROS 3 MESES, LUEGO $4500

Acceso ilimitado a www.eldia.com

Diario El Día de La Plata, fundado el 2 de Marzo de 1884.

© 2026 El Día SA - Todos los derechos reservados.

Registro DNDA Nº RL-2024-69526764-APN-DNDA#MJ Propietario El Día SAICYF. Edición Nro. 6986 Director: Raúl Kraiselburd. Diag. 80 Nro. 815 - La Plata - Pcia. de Bs. As.

Bienvenido

Estimado lector, muchas gracias por su interés en nuestras notas. Hemos incorporado el registro con el objetivo de mejorar la información que le brindamos de acuerdo a sus intereses. Para más información haga clic aquí

Ante cualquier inconveniente durante el inicio de sesión, por favor escribanos a sistemas@eldia.com

Bienvenido

Estimado lector, con sólo registrarse tendrá acceso a 80 artículos por mes en forma gratuita. Para más información haga clic aquí

DATOS PERSONALES

Ante cualquier inconveniente durante el inicio de sesión, por favor escribanos a sistemas@eldia.com

¿Querés recibir notificaciones de alertas?

Para comentar suscribite haciendo click aquí